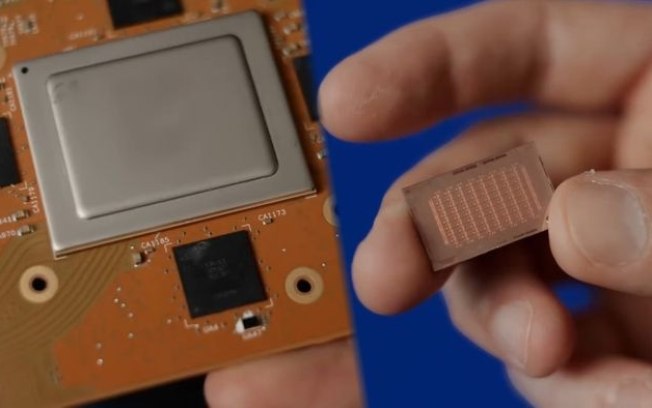

Nesta quarta-feira (10), a Meta apresentou a segunda geração dos chips MTIA (Meta Training and Inference Accelerator) para infraestrutura própria de IA . Desenvolvidos sob medida para alimentar os servidores da companhia, o MTIA v2 traz 3,5 vezes mais desempenho computacional e 1,5x mais desempenho por watt que a geração anterior.

O novo chip proprietário já está operando nos data centers da Meta, atendendo aos principais modelos LLM de IA que alimentam e impulsionam os sistemas de classificação e recomendação de anúncios do Facebook e do Instagram . Além disso, a novidade mostra que a companhia está em busca de autossuficiência e independência de empresas terceiras, notadamente a NVIDIA, dominante no fornecimento de soluções voltadas para IA.

Segundo a corporação, os MTIA operam como um complemento altamente eficiente para as GPUs para IA disponíveis no mercado , entregando um excelente equilíbrio entre desempenho e eficiência em caragas de trabalho específicas às operações da Meta em seus vários segmentos de atuação.

-

Siga o Canaltech no Twitter

e seja o primeiro a saber tudo o que acontece no mundo da tecnologia.

-

Solução fullstack personalizada

Os novos MTIA são fabricados em tecnologia de 5 nm da TSMC , trazem TDP de 90W e frequências de 1,35 GHz. Além disso, a nova geração traz barramento PCIe 5 de largura de banda de 32 GB/s contra os PCIe 4 de 16 GB/s dos MTIA v1.

Mais do que entregar um hardware dimensionado para as cargas de trabalho específicas da Meta, os chips proprietários também visam otimizar o desenvolvimento ao nível de software . Ao atuar como um acelerador dedicado com instruções específicas incorporadas no firmware do MTIA, o desenvolvimento e depoly de soluções em PyTorch é bastante simplificado.

| Especificações MTIA (Meta Training and Inference Accelerator) | ||

| Chip | MTIA v1 | MTIA v2 |

| Fabricação | TSMC 7 nm | TSMC 5 nm |

| Frequência | 800 MHz | 1,35 GHz |

| Barramento | PCIe4 (16 GB/s) | PCIe 5 (32 GB/s) |

| TOPS GEMM (Multplicação Matricial Geral) |

102,4 TFLOPS/s (INT8) 51.2 TFLOPS/s (FP16/BF16) |

708 TFLOPS/s (INT8) (sparsity) 354 TFLOPS/s (INT8) 354 TFLOPS/s (FP16/BF16) (sparsity) 177 TFLOPS/s (FP16/BF16) |

| TOPS SIMD (Instrução Única / Múltiplos Dados) |

3.2 TFLOPS/s (INT8/FP16/BF16) 1.6 TFLOPS/s (FP32) |

5.53 TFLOPS/s (INT8/FP16/BF16) 2.76 TFLOPS/s (FP32) |

| Memória | 64 GB | 128 GB |

| Largura de Memória | 176 GB/s | 204,8 GB/s |

| TDP | 25 W | 90 W |

Por isso, a Meta já declarou que o investimento nos chips próprios é uma iniciativa a longo prazo para otimizar ao máximo os processos de implantação e evolução dos usos de IA em seus serviços, de ponta a ponta, fazendo do MTIA uma solução fullstack.

Ainda por se tratar de uma solução complementar, ela está totalmente adaptada para operar tanto nos servidores atuais quanto eventuais novos racks de 72 GPUs para IA que a Meta possa adquirir no futuro.

- 🛒 Compre processador Intel Core pelo melhor preço!

- 🛒 Compre placa de vídeo NVIDIA GeForce RTX pelo melhor preço!

Leia a matéria no Canaltech .

Trending no Canaltech:

- WhatsApp terá opção para publicar stories no Instagram

- Reator de Fukushima é fotografado pela 1ª vez desde acidente

- Engenheiro desmonta Cybertruck e fica chocado com a bateria

- Vídeo da SpaceX mostra eclipse solar visto do espaço

- X-Men ‘97 traz a primeira grande conexão com o MCU

- 🔥 PARCELADO | Compre Samsung Galaxy Tab S9 FE em ótimo preço